안녕하세요!

D.U.T입니다!

클릭 및 방문해 주셔서 감사합니다!

방문해 주시는 모든 분들에게 항상 도움이 되는 정보를 제공하도록 노력하겠습니다.

이번 포스팅은 엔비디아(NVIDIA) A100 Tensor 코어 GPU에 들어가는 HBM2e(메모리) 비중에 대해 알아보려고 합니다.

HBM2e(메모리)에 대해 설명하기에 전에 짧게 엔비디아(NVIDIA) A100 Tensor 코어 GPU를 설명드리겠습니다.

◈ 엔비디아(NVIDIA) A100 Tensor 코어 GPU?

엔비디아(NVIDIA) A100 텐서 코어 GPU는 가속화를 제공하여 AI의 딥 러닝 트레이닝, 딥 러닝 추론, 데이터 분석을 지원합니다.

엔비디아(NVIDIA) A100은 전 세계 빅테크 기업들이 사용하는 NVIDIA 데이터센터 플랫폼의 엔진입니다.

엔비디아 홈페이지를 참고하여 설명드리면 A100을 클라우드와 데이터 센터에 사용하는 기업은 아래로 확인됩니다.

1. 알리바바 (Alibaba Cloud)

2. 아마존(AWS)

3. 바이두(Baidu Cloud)

4. 구글(Google Cloud)

5. 마이크로소프트(Microsoft Azure)

6. 오라클(Oracle Cloud)

7. 텐센트(Tencent Cloud)

유명한 전 세계 빅테크 기업들이 인공지능(AI)을 위해 엔비디아(NVIDIA) A100 텐서 코어 GPU를 사용하고 있습니다.

정말 많은 기업들이 사용하고 있네요.

예전부터 AI와 관련된 기사를 보면 엔비디아(NVIDIA) A100 및 H100 GPU를 찾는 수요가 폭발적으로 늘어나고 있다는 내용을 많이 접했습니다.

아... 엔비디아(NVIDIA) 주ㅅ... 을 미리 샀다면... ㅠㅠ

아무튼, 엔비디아(NVIDIA) A100에 들어가는 GPU는 엔비디아가 잘 설계했을 것 같고...

GPU와 단짝인 메모리는 어느 회사 제품이 들어가고 비중이 어느 정도 되는지 궁금해서 개인적으로 찾아본 결과를 정리해 봤습니다.

◈ 엔비디아(NVIDIA) A100 GPU와 HBM2e(메모리) 스펙!

엔비디아 홈페이지에서 A100 GPU와 HBM2e(메모리) 스펙을 확인해 봤습니다.

메모리는 HBM2e로 고대역폭 메모리를 사용하고 있고 메모리 크기는 제품 이름처럼 80GB입니다.

메모리 크기가 80GB?!!!

크기가 장난 아닙니다. 역시 대규모 병렬처리가 필요하기 때문에 많은 메모리가 필요한 것 같습니다.

◈ 엔비디아(NVIDIA) A100 하드웨어 구성

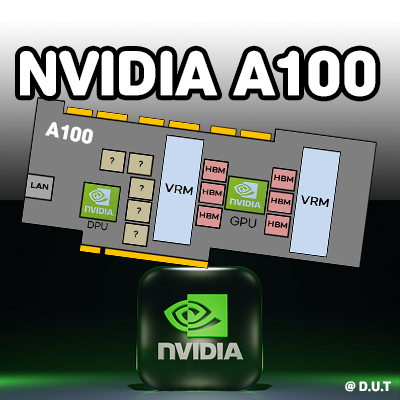

엔비디아(NVIDIA) A100 Tensor 코어 GPU 무료 사진을 구할 수가 없어서 직접 그려봤습니다.

커버를 덮으면 일반 그래픽카드랑 동일합니다. 커버를 제거하면 엔비디아(NVIDIA) A100 PCB에 포함되어 있는 대표적인 하드웨어 부품 구성은 위 사진과 동일합니다.

※ 참고로 각 부품들의 위치는 정확하지 않을 수 있습니다. 제가 사진 및 다른 정보를 참고하여 배치했습니다.

<대표 부품>

1. 그래픽 처리 장치(GPU)

2. 데이터 처리 장치(DPU)

3. Voltage regulator module(VRM)

4. High Bandwidth Memory(HBM)

제가 관심 있는 부품은 High Bandwidth Memory(HBM)입니다.

HBM을 짧게 설명드리면 짧은 메모리 레이턴시와 높은 메모리 대역폭, 낮은 전력 소모를 가지는 장점을 가지고 있습니다.

위에서 메모리 크기가 80GB인 것을 알았습니다. 엔비디아(NVIDIA) A100 GPU 하드웨어 부품을 확인해 보니 6개의 HBM이 있는 것으로 추정합니다.

그러면 80GB / 6를 하면 1개의 HBM의 메모리 크기는 13.33GB입니다.

13.33GB???

이상합니다. 정수로 안떨어지네요. 확인해보니 6개의 HBM을 사용하지만 1개의 HBM은 어디에 사용하는지 잘 모르겠습니다. 공식 스펙은 80GB입니다만, 나머지 1개 16GB는 어디에 사용할까요? 궁금하네요.

◈ 엔비디아(NVIDIA) A100의 HBM2e는 SK 하이닉스?!

이제 엔비디아(NVIDIA) A100 GPU에는 어떤 회사가 HBM2e(메모리)를 공급하는지 찾아봤습니다.

SK 하이닉스 홈페이지와 기사 및 증권 자료 등, 여러 가지 정보를 종합해 보면 엔비디아(NVIDIA) A100 GPU에HBM2e(메모리)는 SK 하이닉스 제품이 사용되는 것으로 확인됩니다.

SK 하이닉스 제품을 사용하는 이유를 찾아보니 SK 하이닉스가 HBM을 먼저 시작하였고 HBM2e(메모리)는 SK 하이닉스 기술이 뛰어나다고 알려져있다고 합니다.

SK 하이닉스 홈페이지에서 HBM2e(메모리) 제품을 찾아봤습니다.

HBM2e(메모리) 제품은 4개가 있습니다. 용량은 모두 16GB입니다.

앞에서 엔비디아(NVIDIA) A100 GPU의 HBM 메모리 크기는 80GB(부품 수량으로는 96GB)인 것을 확인했고 1개당 용량 크기는 16GB이므로 SK 하이닉스 제품이 맞는 것 같습니다.

마지막으로 HBM2e(메모리) 제품 1개 16GB는 얼마인지 궁금해서 찾아봤습니다.

Part no.로 인터넷에 검색을 해봤습니다. B2C로는 판매하지 않는지 가격 정보는 정확하게 없었습니다.

TrendForce 자료를 참고해 보면 2022년 HBM2e의 1GB당 가격은 약 $13.7로 확인됩니다.

★ HBM2e(메모리) 16GB 제품 가격 추정치: $219.2 = 28만 137.60원

(환율 1278원 기준)

상당히 비쌉니다. 고부가가치 제품입니다!

SK 하이닉스 흥해라!

SK 하이닉스 주식은 없습니다. 삼성에만 물려있습니다...

◈ 엔비디아 A100 GPU에 HBM2e(메모리) 비중은 몇 %?

HBM2e(메모리) 16GB 제품 가격이 1개당 약 28만원이므로 엔비디아 A100 GPU에서 비중은 몇 % 인지 대략적으로 추정해 봤습니다.

현재(포스팅 기준) 아마존에서 Nvidia A100 80Gb HBM2E Memory Graphics Card PCIe 4.0 x16 Ampere Architecture 기준으로

가격은 $15,489.95

원화로 약1,972만원입니다.

HBM2e(메모리) 16GB 제품 가격이 1개당 약 28만원이므로 6개를 곱하면 약 168만원입니다.

엔비디아 A100 GPU 소비자 판매 가격에 HBM2e(메모리)만 재료비 비중이 약 8.5%이므로 상당히 높은 편입니다. 왜냐하면 소비자 판매 가격이 아닌 원재료비로 보면 HBM2e(메모리) 재료비 비중은 많이 올라가기 때문입니다.

일부 정보를 가지고 추정한 내용이므로 정확하지 않을 수는 있지만 그래도 HBM2e(메모리) 재료비 비중이 높습니다.

지금까지 개인적으로 궁금했던 내용을 정리해 봤습니다. 방문해 주시는 모든 분들에게 도움이 되기 바라며 긴 글 읽어주셔서 감사합니다.

※ 이 포스팅은 국내 주식, 해외 주식 등 매수 매도 추천 포스팅이 아닙니다.

※ 모든 투자에 대한 책임은 투자자 본인에게 있습니다.

'AI (인공지능)' 카테고리의 다른 글

| 하이브리드 AI 개념, 공부 내용 정리! (By. 퀄컴) (0) | 2024.04.07 |

|---|---|

| HBM3 메모리는 어디에 사용될까? (ft. 엔비디아, AMD) (0) | 2023.08.19 |

| AI 시대, 데이터는 왜 중요할까? 인공지능의 밥: 데이터! (0) | 2023.07.23 |

| 풀 스택(Full-stack) AI와 수직(Vertical) AI란? (ft.테슬라) (0) | 2023.04.23 |

| AI 반도체(AI 하드웨어 가속기=NPU), 개념+기초 정리! (0) | 2023.04.16 |